Конференция Nvidia GTC 2024 открылась официальным анонсом архитектуры GPU нового поколения Blackwell, продукты на основе которой появятся в конце года.

Компания предложит три GPU для ЦОДов и задач искусственного интеллекта — B100, B200 и GB200. Последний, наиболее мощный, будет состоять из двух GPU и центрального процессора Grace.

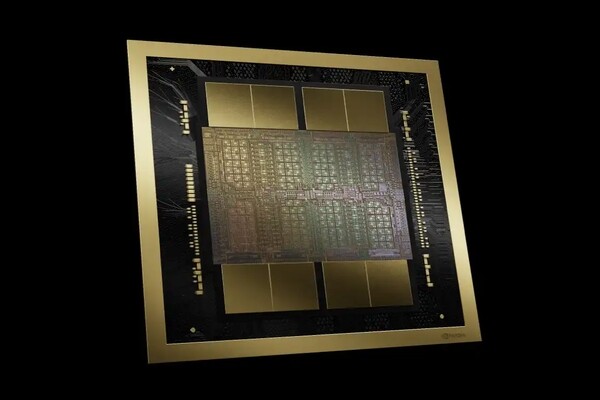

В какой-то мере новая архитектура, подобно GPU компании AMD, предполагает использование блоков («чиплетов») — процессоры состоят из двух больших кристаллов, связанных интерфейсом на 10 Тбайт/с.

Как заявляют в Nvidia, у GB200 будет в семь раз более высокая производительность инференса, вчетверо более высокая производительность обучения и в 25 раз лучшая энергоэффективность, чем у его предшественника GH200, основанного на архитектуре Hopper. Как подсчитали в компании, благодаря высоким характеристикам энергоэффективности масштаб систем ИИ в ЦОДах можно будет легко увеличить, оснастив их более чем 100 тыс. GPU.

В Nvidia рассказали о «трансформаторном движке» (transformer engine) второго поколения в Blackwell, который следит за характеристиками работы нейронной сети и автоматически выбирает для каждого ее слоя математическую точность весовых коэффициентов. В Blackwell она варьируется от FP4 (4 знака после запятой) до FP64 (64 знака) с шагом по степеням двойки. Чем больше точность, тем ниже производительность и выше расход энергии. В Nvidia сообщили, что производительность FP8 у Blackwell составляет 4 PFLOPS — вдвое с лишним больше, чем у Hopper.

Как объясняют специалисты компании, предыдущие поколения требовали программировать переключение точности весовых коэффициентов вручную, тогда как Blackwell делает это в автоматическом режиме и безопасно, поскольку новая архитектура сохраняет значения с более высокой точностью, чем это нужно для решения задачи.

Blackwell поддерживает интерфейс межпроцессорных соединений NVLink пятого поколения, который, как сообщают в Nvidia, обеспечивает в 18 раз более высокую пропускную способность по сравнению с предыдущим, позволяя обрабатывать на многоузловых системах модели ИИ с триллионами параметров.

Вместе с новыми GPU анонсирована основанная на Infiniband сетевая инфраструктура для систем искусственного интеллекта Quantum-X800, предназначенная, согласно описанию, для «многопользовательских облаков генеративного ИИ» и ЦОДов крупных предприятий. Основа X800 — коммутатор и сетевой адаптер, обеспечивающие сквозную пропускную способность 800 Гбит/c, впятеро больше по сравнению с предыдущим поколением. Эти устройства появятся в следующем году.

.jpg)