От возможностей — к потребностям

Не рискуя сильно ошибиться, можно утверждать, что в последнюю четверть ХХ в., характеризовавшуюся бурным развитием ИКТ, компании-производители предлагали для рынка и пользователей главным образом продукты и технологии, стремясь при этом продемонстрировать их возможности, а отнюдь не эксплуатационную приспособленность. В рыночных решениях основное внимание уделялось обработке информации, в частности ее передаче, хранению, организации доступа, документированию и т.п. На этом пути получены весьма значимые результаты по объемам обрабатываемой информации, скоростям передачи и видам доступа. Но в реальных условиях все чаще звучат требования заказчиков, связанные с тем, что в ходе эксплуатации необходимо постоянно повышать ее эффективность. Причем им приходится переходить от того, что известно об эффективности эксплуатации на основе лишь учетной информации, к знаниям, получаемым в результате аналитической работы, базирующейся, как правило, на весьма сложных вычислениях. А трудности реализации таких вычислений определяются не только задачами, возникающими при эксплуатации систем, например корпоративных информационных, но и тем, что для их решения требуются более совершенные программно-аппаратные средства, нежели те, которые доступны при использовании отдельных ПК, рабочих станций и даже серверов. Скажем, для решения задач обработки информации в интересах компаний, ведущих геологическую разведку и эксплуатацию нефтяных и газовых месторождений, лишь для анализа данных сейсморазведки приходится строить модели сложных вычислительных процессов на основе терабайтных объемов исходных данных, в этих моделях используются современные математические методы, причем они должны удовлетворять реальным требованиям по времени расчетов. Поэтому особый интерес у заказчиков ИТ вызывает связанная с суперкомпьютерами ниша рынка, активно развивающаяся в последние годы. И читателям «Мира ПК» полезно узнать не только о том, что в Галисии будет создан суперкомпьютер с самым большим объемом памяти в Европе, о чем сообщили компании Hewlett-Packard и Intel, а также организации Xunta de Galicia и Высший совет научных исследований, но и о выходе 4-й редакции списка самых мощных компьютеров СНГ Top50 (www.supercomputers.ru/&page=rating).

Суперкомпьютер Finis Terrae будет иметь в своем составе 142 узла, включающих по 16 процессорных ядер Intel Itanium 2 и 128 Гбайт памяти. Кроме того, вычислительная система будет иметь два узла по 128 процессорных ядер (один — с 384 Гбайт памяти, другой — с 1024 Гбайт). Этот суперкомпьютер массой около 33,5 т занимает площадь 140 м?. Его планируется интегрировать во всемирную сеть исследовательских центров, охватывающую более 20 стран, и он станет одной из крупных сред для численного моделирования различных проблем. Предполагается сдать Finis Terrae в эксплуатацию в середине 2007 г.

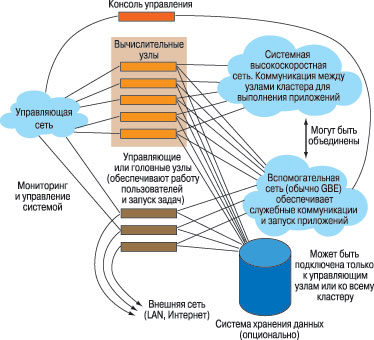

О положении в СНГ с суперкомпьютерами можно получить представление из последней редакции списка Top50, откуда следует, что последние полгода (после представления предыдущей его редакции) в эксплуатации находятся 18 новых суперкомпьютерных систем. Примерная блок-схема такой системы представлена на рис. 1, общий вид суперкомпьютера изображен на рис. 2.

|

| Рис. 1 |

|

| Рис. 2 |

В списке лидирует установленный в МСЦ РАН суперкомпьютер кластерного типа МВС-1500ВМ с 1148 процессорами (он дополнился 224 новыми процессорами IBM PowerPC), обеспечивающими на тесте Linpack производительность, равную 6680 GFLOP. И хотя он все еще отстает в 42 раза от самого производительного суперкомпьютера Ливерморской национальной лаборатории (США), все же следует отметить, что «входной балл» по производительности для суперкомпьютеров при включении в новую редакцию рейтинга Top50 вырос более чем в 2 раза и составил 139 GFLOP. А суммарная производительность всех систем, участвовавших в рейтинге, выросла за полгода на 27% и достигла 23,2 TFLOP.

Рассмотрим характеристики парка суперкомпьютеров в России и СНГ. В.В. Воеводин, член-корреспондент РАН, назвал эти системы «локомотивами ИТ». Процессорная платформа суперкомпьютеров включает устройства компаний Intel (50%) и IBM (25%). Доля компьютеров собственной сборки падает, но растет количество полученных от производителей. В 4-й редакции списка значительную часть составили суперкомпьютеры, содержащие от 33 до 64 процессоров.

Интересно распределяются суперкомпьютеры по областям использования. Если сравнивать данные Top50 с мировым уровнем, то в промышленности задействованы 28% суперкомпьютеров, указанных в рейтинге, тогда как в мире — 34%, в исследовательской сфере — 18 против 32,8%, в науке и образовании — 20 против 14,2%, в финансах — 34 против 8,6%.

Так, в первую десятку суперкомпьютеров 4-го рейтинга Top50 входят кластеры рыбинского НПО «Сатурн», производящего двигатели для авиапрома и других отраслей промышленности. Кроме того, в число лидеров входят компании Paradigm Geophysical и Landmark, обслуживающие нефтегазовый комплекс. Эти кластеры обеспечивают решение широкого класса задач от моделирования, связанного с проектированием и производством принципиально новой продукции, до обработки данных изысканий для построения приемлемых пространственных моделей месторождений и оценки их потенциала. В качестве примера параметров задач, решаемых на суперкомпьютерах Paradigm Geophysical, сошлемся на данные, представленные на пресс-конференции в прошлом году. На основе этих изысканий (их объемы порядка нескольких Тбайт) в приемлемые сроки рассчитывается пространственная «картинка» месторождения для площадей порядка 200х200 км с той точностью, которая позволяет буровикам экономить значительные средства.

О перспективах использования суперкомпьютеров в образовательных и научных организациях России, Белоруссии и Украины говорят итоги конкурса, проведенного НИВЦ МГУ им. М.В. Ломоносова, ИПС РАН, корпорациями Sun Microsystems и AMD и компанией «Т-Платформы». В рамках комплексной Программы по оснащению вузов и научных организаций высокопроизводительными кластерными решениями «Высокие технологии — отечественной науке и образованию», анонсированной НИВЦ МГУ, ИПС РАН и компанией «Т-Платформы» в сотрудничестве с фирмой «ТЕСИС», в марте 2006 г. были подведены итоги конкурса на лучший проект использования кластерного решения.

В нем приняли участие 39 организаций из 21 города, представившие 44 проекта из России, шесть с Украины и два из Белоруссии. Среди 17 проектов московских организаций восемь предложил МГУ. Особый интерес вызвало участие в конкурсе техникумов, в частности, из шести тульских проектов один был представлен техникумом.

Как сказал, подводя итоги, член-корреспондент РАН С.М. Абрамов, директор ИПС РАН, по рассмотренным конкурсным проектам создается впечатление, что Россия изголодалась по HPC-технологиям (High-Performance Computing, высокопроизводительные вычисления).

Представленные решения имели следующую направленность: проблемы безопасности (26% общего числа), промышленные задачи (17%), математика и параллельные вычислительные технологии (13%), синтез новых материалов и нанотехнологии (7%), медицина (7%), астрономия и обработка данных, получаемых со спутников (5%), ядерная физика (3%) и прочее (13%).

Диапазон проектных задач также весьма широк: прогнозирование чрезвычайных ситуаций, защита населения и объектов при экстремальных природных явлениях и техногенных катастрофах, включая экологический мониторинг значительных районов страны и земного шара; выполнение инженерных расчетов, связанных с моделированием проектируемых летательных аппаратов, промышленных агрегатов и двигателей, проблем разработки месторождений полезных ископаемых, в частности геологоразведки, и оптимизации процессов добычи; создание вычислительных систем для нужд учреждений среднего и высшего образования, а также решение прочих исследовательских задач. Призы конкурса вручали компании «Т-Платформы», Sun Microsystems и AMD.

Первый приз конкурса, 10-узловой кластер Т-Fire20, программно-аппаратное решение от компании «Т-Платформы», был присужден проекту химического факультета МГУ. Он предназначен для задач, требующих обработки больших объемов данных и высокой скорости вычислений. Являющиеся узлами системы серверы Sun Fire X2100 вместе с высокопроизводительной внутренней связью между компонентами и комплектом системного и управляющего ПО и образуют этот суперкомпьютер для высокопроизводительных вычислений. Однопроцессорный сервер в компактном формфакторе 1U объединяет двухъядерный 64-разрядный процессор AMD Opteron 100, высокоскоростную технологию подсистемы ввода-вывода PCI Express, четыре модуля оперативной памяти, до двух жестких дисков SATA 2 интегрированных сетевых портов. Сервер имеет также дополнительную карту для технического обслуживания и управления SMDS (Switched Multimegabit Data Service — служба коммутируемой многомегабитовой передачи данных) с поддержкой стандарта IPMI 1.5 и снабжается предустановленной операционной системой Solaris 10 и программным обеспечением Sun N1 System Manager, позволяющим управлять многими системами Sun 64 как одним сервером. Нет ограничений и по работе под управлением ОС Windows или Linux.

Второго приза, шестиузлового кластера T-Fire12, был удостоен проект ИВМ РАН, а третий получил проект АНО «Научный центр ГДТ Софтвер Гроуп» из Тулы.

Поощрительной премией в виде сервера TEco от компании «Т-Платформы» была отмечена работа «Высокопроизводительный молекулярный дизайн для наук о живом», выполненная на факультете биоинженерии и биоинформатики МГУ. Ее реализация позволит заниматься молекулярным моделированием виртуального скрининга библиотек химических соединений с целью поиска потенциальных лекарственных препаратов, создания рационального дизайна белков и биокатализаторов для биотехнологических процессов и др. Кроме того, в семи дополнительных номинациях были награждены полнофункциональными комплектами средств управления вычислительными ресурсами Sun N1 Grid Engine, позволяющими также пользоваться сетевыми ресурсами, проекты вузов и институтов из Кемерова, Калининграда, Москвы, Новосибирска, С.-Петербурга, Тамбова и Харькова.

Удивление — результат счета

На конкурсе рассматривались не только те работы, где раскрывались возможности использования существующих суперкомпьютеров, но и те, в которых более мощные вычислительные средства приводили бы к существенно более эффективным результатам. Потому первую премию получил проект «Прототипы наноавтомобилей на основе высокопроизводительных расчетов методами молекулярного моделирования», представленный химическим факультетом МГУ. Он не только опирается на значительный научный вклад в виде проделанных исследований и публикаций в журналах, но вместе с тем работы данного направления имеют весьма широкие практические перспективы.

Нанотехнологии представляют значительный интерес и служат поставщиками множества реальных вычислительных задач. Коллектив сотрудников химфака во главе с профессором А.В. Немухиным ведет исследования химических соединений, способных образовывать объекты, могущие перемещаться в пространстве. В конкурсном проекте такой объект называется «наноавтомобиль» (рис. 3), потому что его образ — база с четырьмя колесами, двумя осями для них и одной связующей их поперечной осью.

|

| Рис. 3. Молекулярная структура прототипа наноавтомобиля |

Основа молекулярной конструкции наноавтомобиля — «колеса» из четырех молекул фуллерена, каждая из которых образована 60 атомами углерода. Такие колеса химически «привиты» к осям, представляющим собой сочленения относительно жестких органических молекул с кратными связями. Задача, рассматриваемая в проекте, заключается в моделировании свойств молекулярных устройств, прототипами которых являются наноавтомобили, путем выполнения расчетов методами молекулярной динамики (МД) и комбинированными методами квантовой и молекулярной механики (КМ/ММ). Причем требования к объемам и времени выполнения вычислений будут весьма существенными; это и определило цель, поставленную в данном проекте: на основе новейших достижений экспериментальной нанотехнологии создать молекулярный конструктив, напоминающий базу автомобиля, способного перемещаться при нагревании по поверхности кристалла золота.

Конкретной задачей моделирования стал поиск приемлемого химического состава и структуры молекул, составляющих оси и позволяющих осуществлять вращение колес из тех самых фуллеренов вокруг этих осей. Причем это будет делаться существенно эффективнее, чем в первых экспериментальных образцах. Основная проблема при поиске такого режима вращения колес наномашины состоит в том, чтобы движение соответствовало не только направлению прикладываемого импульса, но и уменьшало ее раскачивание. Поэтому исследование опиралось на методы молекулярной динамики наносистем.

Для массовых расчетов траекторий движения моделей наноавтомобилей с различными вариантами химического строения состава осей предлагается оригинальная компьютерная программа молекулярной динамики систем с жесткими фрагментами. При таком подходе можно выполнять расчеты в допущении, что колеса всего лишь жесткие фрагменты с шестью степенями свободы, т.е. МД-моделирование становится практически реализуемым.

Успех этого моделирования зависит и от ряда других факторов, например от учета потенциалов взаимодействия частиц в системе. В существующих БД параметров силовых полей, обычно используемых для расчетов МД, не всегда можно найти нужные, и потому их также необходимо определять, в частности, с помощью уже разработанных программ КМ/ММ (пакет программ PC GAMES).

Оценка предполагаемого по проекту объема вычислений свидетельствует о том, что их невозможно выполнить без использования вычислительных кластеров и методологии распараллеливания алгоритмов. В лаборатории химфака МГУ была проведена оценка необходимой платформы суперкомпьютера в части коммуникационной сети, и предпочтение было отдано в пользу технологии Infiniband в качестве средства обмена данными между узлами. При выполнении МД-расчетов для снижения расходов на распараллеливание вычислительного процесса предлагаются средства Remote Direct Memory Access.

Разумеется, заслуживают внимания предложения о потенциальных областях применения результатов реализации проекта. Вот лишь некоторые. В частности, высказывается мысль о создании нанороботов на основе наноавтомобилей с оптимальным составом осей, наноразмерных транспортеров, подшипников и проч. Пока еще результаты подобных расчетов вызывают лишь удивление, но, думается, придет время, и они перейдут из разряда уникальных в массовые благодаря применению полученного суперкомпьютера.

Как быть с большими задачами?

Интерес к вычислительным задачам испокон века всегда ограничивался объемом исходных данных и временем счета, поэтому история вычислительной техники по сути есть борьба за размер памяти и скорость работы машин. Но неизбывный конфликт между желанием решать задачи, размерность которых не соответствует возможностям современных компьютеров, породил такое понятие, как «большие задачи», и вынудил математиков искать обходные пути, в частности осуществлять «сжатие» объема исходных данных до приемлемых размеров, что позволит выполнять работу на доступной программно-аппаратной платформе за приемлемое время. Таким образом, появление конкурсного проекта, связанного с развитием математических методов, направленных на снижение требований к объему данных, необходимых для решения практически важных классов задач, вызвало интерес экспертов к нему. Проект «Параллельные технологии построения тензорных аппроксимаций для решения больших задач», представленный профессором Е.Е. Тыртышниковым с сотрудниками из ИВМ РАН получил на конкурсе вторую премию. Он посвящен приближенному представлению многомерного массива данных. При этом значительно (до миллиарда раз) экономятся потребляемая память и вычислительный ресурс (количество необходимых узлов в суперкомпьютере).

К сожалению, принципиальное изложение математической сути данного проекта потребует весьма глубокого погружения в тензорное исчисление, и потому придется ограничиться краткой информацией о нем.

Известная цепь представления данных: число, вектор, матрица — интересна тем, что каждое последующее ее звено позволяло реализовывать те или иные способы сжатия данных, описанных набором элементов предыдущего звена, тем самым отодвигая границы решаемых больших задач. Теперь подошли к тензору (см. Большой энциклопедический словарь. Математика. М., 1998. С. 579), с помощью которого авторы проекта и решают проблемы сжатия объема данных.

Таким образом, осуществление данного проекта не только развивает методы сжатия данных, но и реализует их на суперкомпьютере, при этом получается реальная оценка эффективности этих методов. С использованием предложенной методологии можно решать практические задачи электромагнитного рассеяния и распознавания речи. Кроме того, этим методом с помощью суперкомпьютеров можно проводить поиск эффективных решений интегральных уравнений, решать задачи обработки сигнала, в частности радиолокационные и задачи ядерного магнитного резонанса, выполнять факторный анализ, обеспечивать эффективную обработку больших массивов звуковой, графической и видеоинформации.

В завершение представления этого проекта следует сказать о конфигурации суперкомпьютера, нужного для решения изложенной выше задачи. Если размерность трехмерного массива, тензорную аппроксимацию которого необходимо построить, равна примерно 1 млн., тогда требования существующего алгоритма аппроксимации к используемой памяти можно представить как 6 nr, где n — размерность строки, описывающей исходные данные, r — ранг тензора. В дальнейшем при последующих операциях эти требования возрастут в r раз. При r=64, что равно вероятному значению для практических задач, потребуется память не меньше 384 Гбайт. Следовательно, для решения задачи будет достаточной вычислительная система, имеющая 25 узлов с 16 Гбайт памяти на каждом из них. Так как для реализации алгоритма понадобятся активные межпроцессорные коммуникации, то скорость работы соединительной сети должна быть не ниже 2 Гбит/с. Для адресации используемой памяти процессоры должны иметь 64-разрядную архитектуру.

Богатства вычислительной практики

Третьего приза конкурса удостоено АНО «Научный центр ГДТ Софтвер Гроуп» за комплекс проектов численного моделирования быстропротекающих процессов. Эта тульская команда под руководством профессора А.В. Зибарова разработала программные средства, позволяющие решать следующие классы задач:

- анализ и прогноз последствий взрывов в ограниченных и полуограниченных объемах;

- численное моделирование турбулентных процессов в газах;

- моделирование ударно-волновых процессов;

- численное моделирование трехмерных процессов горения проницаемых сред;

- численное моделирование трехмерных процессов детонации;

- прогнозирование и визуализация последствий чрезвычайных ситуаций и оценка воздействий на окружающую среду промышленных объектов.

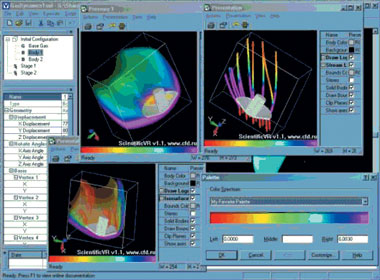

Цель, которую выдвинули участники этого проекта, основанного на разработанных ими пакетах GasDynamicsTool (GDT) и ScientificVR (SVR), — создать программно-аппаратные комплексы, с помощью которых можно с высокой точностью моделировать процессы взрыва, горения, распространения вредных веществ в атмосфере и прочие, сопутствующие возникновению аварий и чрезвычайных ситуаций (рис. 4). Реализация проекта позволит способствовать решению на более высоком уровне важных задач, связанных с защитой населения: обеспечение пожаро- и взрывобезопасности зданий, прогноз и развитие чрезвычайных ситуаций, разработка эффективных мер предупреждения и реагирования на террористические атаки.

Данный проект интересен следующим. Во-первых, это классический пример поддержки процессов вычислений для широкого круга научно-практических задач, использующих различные аппаратные платформы и математические методы, большой программистский опыт, а следовательно, обеспечивающих значительный объем применений в самых различных областях науки, промышленности и даже государственного управления прежде всего путем постановки и решения самых разнообразных задач.

Во-вторых, реализация данного проекта обращает внимание широкого круга пользователей на такую важнейшую сторону ИТ, которая проявляется лишь при моделировании поведения процессов и функционирования систем в целом.

Проект следует также рассматривать с учетом того, насколько модельные представления являются тем рычагом, который обеспечивает более эффективное решение самых разных задач, связанных как со структурами данных, так и самих систем. Подобный подход ожидается в ИТ-мире и требует поддержки его развития у пользователей.

Для представления об уровне этого проекта полезно дать краткую характеристику пакетов GDT и SVR, а также имевшему место его использованию.

Первая версия GDT вышла еще в 1988 г., теперь входящие в его состав средства поддерживают параллельные алгоритмы при реализации их на многопроцессорных вычислительных системах. Кстати, при использовании вычислительного кластера коэффициент эффективности (его загрузки) достигает 0,96—0,98.

К областям применения пакета можно отнести поддержку процессов проектирования новых образцов авиационной и космической техники, а также решение задач в области экологии и обеспечения безопасности и антитеррористической деятельности. С помощью GDT можно решать следующие задачи:

- исследование процессов течения вязких газов, сопровождающихся теплопередачей и диффузией, течения химически реагирующих газовых смесей;

- расчет теплопереноса в телах;

- расчет газодинамических характеристик трехмерных, плоских и осесимметричных течений;

- расчеты, связанные с нестационарными процессами в широком диапазоне начальных и граничных условий;

- расчет характеристик дозвуковых и сверхзвуковых течений;

- численное моделирование нестационарных процессов в системе газов и тел произвольной геометрической формы;

- численный анализ стационарных процессов в режиме стабилизации;

- численное моделирование мультифазных процессов, включающих двухфазные химические реакции.

Весьма представительным является набор содержательных моделей, для которых проводятся вычисления с помощью GDT. Им соответствуют такие программные части комплекса:

- "Эйлер" - поддерживает решение систем уравнений в координатах Эйлера;

- "Навье-Стокс" - позволяет моделировать трехмерные химически реагирующие течения вязкого газа с использованием кинетического уравнения Аррениуса;

- "Конденсированные взрывчатые вещества" - обеспечивает моделирование двух- и трехмерных процессов детонации конденсированных взрывчатых веществ, движение в данных подмоделях описывается системой уравнений Эйлера;

- "Двухфазность" - осуществляет моделирование трехмерных двухфазных течений с химической реакцией твердой и газообразной составляющих;

- "Подструктура" - часть комплекса, используемая для моделирования газодинамических течений с присутствием проницаемости объектов. Она вводится посредством сеточной структуры, которая изменит свой объем на основе различных критериев, позволяющих моделировать химические реакции, испарения, конденсацию веществ. Может применяться в случае горения пороховых зарядов или детонации пористых взрывчатых веществ.

При решении задач GDT позволяет организовывать вычислительный процесс под управлением ОС Windows, Unix, Linux и Solaris, что предоставляет пользователю широкий круг возможностей, например, можно задавать различные граничные условия в любой точке области, где ищется решение, оперативно изменять и сохранять конфигурацию моделируемого процесса и области, где он протекает, и проч. (рис. 4).

|

| Рис. 4. Графический интерфейс пользователя пакета GDT |

О быстродействии GDT можно судить хотя бы на примере расчета, проведенного на суперкомпьютере МВС-1000 в ИАП РАН (16-узловой кластер с 32-Гбайт оперативной памятью). Область этой задачи имела объем в 960 млн. трехмерных ячеек, и на одну итерацию потребовалось 39 с. (Для сравнения: на ПК с процессором Intel Centrino, имеющим тактовую частоту 1 ГГц, расчет одной итерации для задачи с 1 млн. трехмерных ячеек длится 1 с.)

Другой пакет SVR, на который опирается численное моделирование в проекте, получившем третий приз на конкурсе, служит в качестве средства визуализации результатов расчета. Этот многофункциональный визуализатор разрабатывается «Научным центром ГДТ Софтвер Гроуп» начиная с 2000 г. Модульная многослойная архитектура пакета позволяет дополнять его новыми функциональными возможностями путем подключения внешних модулей.

Вот краткая характеристика SVR. Чтобы представить распределение трехмерных параметров в пакете, применяется технология, основанная на воксельной графике с использованием полупрозрачных цветовых палитр.

Изоповерхности, являющиеся трехмерным аналогом изолиний, предназначены для визуализации трехмерных полей. Помимо окраски поверхностей цветом любого выбранного параметра можно создавать изоповерхности с различной степенью прозрачности. При визуализации двух- и трехмерных векторных полей с помощью длины и цвета вектора можно одновременно представить несколько параметров. Реализуются и комбинированные изображения с использованием разных возможностей пакета. Оригинальной функцией в SVR является стереовизуализация, осуществляемая с помощью специальной аппаратуры (видеокарта с поддержкой стерео, стереоочки или два проектора с фильтрами и специальный настенный экран), которая позволяет видеть объемную картинку. Кроме этого, применяя SVR, можно создавать анимации двух типов: в виде ролика, показывающего течение процесса во времени, и в виде демонстрации вращающейся области. В состав пакета также входят средства сохранения полученных при моделировании результатов — всего проекта, образов в форматах .png, .bmp, .tiff, .jpeg, .eps, а также видеороликов в форматах, поддерживаемых конкретной ОС. В программе SVR реализована работа с командной строкой.

Перспективы суперкомпьютеров в России

Семь проектов конкурса, удостоенные дополнительных премий, сложились в своеобразную картину, помогающую понять, в каких сферах в нашей стране нуждаются в суперкомпьютерах.

Так, проект создания единого высокопроизводительного вычислительного комплекса для Кузбасса, который предлагает профессор К.Е. Афанасьев из Кемеровского ГУ, позволит решать многие актуальные задачи региона, в частности по обеспечению экологической безопасности угледобывающих районов области, по повышению эффективности реагирования на чрезвычайные ситуации, по исследованию влияния техногенных факторов на окружающую среду, а также рассматривать оптимизацию освоения угольных месторождений.

Балтийский информационный техникум из Калининграда выступил с предложением организовать «Вычислительный кластер MareBalticum». С его помощью в регионе можно подготавливать специалистов по телекоммуникациям, по высокопроизводительным вычислениям, по математическому моделированию, а также по эксплуатации промышленных САПР.

Проект СПБГУИТМО, осуществляемый под руководством профессора А.В. Бухановского, связан с разработкой аппаратно-программного комплекса диагноза и прогноза экстремальных гидрометеорологических явлений, представляющих угрозу безопасности морских и прибрежных объектов и сооружений, с целью снижения рисков при их проектировании и эксплуатации.

Широкое распространение олимпиадного движения привело к тому, что Новосибирский университет выступил с проектом «Применение кластера для онлайн-проверки решения задач в ходе олимпиады». Дело в том, что ресурсные требования к тестированию решений столь высоки, что этот процесс требуется рассматривать на суперкомпьютере.

Развитие математических методов реализации алгоритмов на суперкомпьютерах послужило стимулом для расширения ряда отмеченных конкурсных проектов. Так, профессор И.И. Дзегеленок из МЭИ вместе с группой сотрудников предложил создать библиотеку программ для поддержки вычислений над полем рациональных чисел. Она обеспечивает исключение ошибок округления и возможность расширения диапазона представления чисел в масштабируемой высокопроизводительной кластерной среде. Совершенствованию вычислительного сервиса посвящен проект «Система параллельной компьютерной алгебры», разрабатываемый под руководством профессора Г.И. Малашонка из Тамбовского ГУ им. Г.Р. Державина. Результатом работы над проектом должна стать эта система, размещенная на вычислительном кластере и доступная для удаленного использования.

Седьмой проект, дополнительно поощренный, предложен не из России. Это «Программно-аппаратный комплекс эндопротезирования и сложных хирургических операций» из Харьковского ПИ, руководитель проекта — профессор Н.А. Ткачук. Его актуальность, связанная с предоперационным моделированием, настолько велика, что в любой стране он представляет несомненный интерес. Тем более что это решение базируется на такой платформе, как высоко- производительный вычислительный кластер, позволяющий обслужить самое современное медицинское оборудование, применяемое при сложных операциях.

В завершение статьи повторим слова С.М. Абрамова: «Россия изголодалась по высокопроизводительным вычислениям».

Благодарим компанию «Т-Платформы» и ее менеджера А. Челышева за любезно предоставленные материалы по конкурсу.