Визуальные эффекты играют большую роль в современном сторителлинге (термин введен в 1992 году Дэвидом Армстронгом в книге Managing by Storying Around и в русскоязычной литературе используется именно в такой форме) и применяются не только в постановочных кинофильмах, но и в телевизионных передачах, компьютерных играх и в парках аттракционов. Благодаря современным мощным процессорам, методам компьютерной графики и технологиям отображения визуальные эффекты становятся все более реалистичными, однако требования к их качеству и интерактивности сильно различаются в зависимости от приложений. В кинофильмах требуется исключительно высокое качество визуальных эффектов, для чего обычно используются чрезвычайно мощные компьютерные средства. Визуальные эффекты в телевизионных передачах и компьютерных играх должны обеспечиваться с частотой не менее 25-60 Гц, что можно достичь на обычных домашних ПК, игровых приставках и все более часто – в мобильных телефонах. Во многих парковых аттракционах визуальные эффекты комбинируются со специальными эффектами. Как и в компьютерных играх, в некоторых визуальных эффектах для аттракционов поддерживается интерактивность. Но, в отличие от игр, телевидения и кинофильмов, они могут принести участникам ощущения, которые невозможно обеспечить при демонстрации визуальных эффектов на плоском экране.

Первая основная статья тематической подборки называется «Не верьте своим глазам: новейшие визуальные эффекты» (Don't Trust Your Eyes: Cutting-Edge Visual Effects) и написана Дугом Роублом и Нифизом Бин Зафаром (Doug Roble, Nafees Bin Zafar). «Золотым веком» реальных визуальных эффектов были 80-е годы, и началось все с фильмов «Империя наносит ответный удар» и «Инопланетянин», которые показали, чего можно добиться с помощью сложных моделей, макетов и систем управления движением кинокамер, и закончилось блокбастерами со спецэффектами «Бэтмен» и «Индиана Джонс и последний крестовый поход».

Расцвет эффектов компьютерной анимации (Computer-Generated Imagery, CGI) начался в 90-е годы: постоянно возрастающая мощность компьютеров привела к созданию инструментальных средств, которые позволили разработчиками визуальных эффектов делать вещи, вообще невозможные при применении физических методов. Терминатор Арнольда Шварценеггера модели 101 создавался при помощи грима и сложного макетирования, но уже образец модели T-1000, который играл Роберт Патрик, был порождением CGI. Такие фильмы, как «Звездные войны: эпизод 1 – скрытая угроза» и «Матрица», изобиловали визуальными эффектами, созданными исключительно с использованием CGI, и публика была в восторге.

В последнее десятилетие использование CGI быстро расширялось и углублялось, а традиционные эффекты приходили в упадок. Недавние «Властелин колец» и «Трансформеры» представляют собой наглядные примеры господства CGI, и, по-видимому, это отражается в изменениях, происходящих, в частности, в компании Digital Domain, большая часть деятельности которой поначалу посвящалась традиционным эффектам. В 2000 году в компании имелся крупный цех, производивший поразительно точные физические модели, а также две большие сцены, на которые можно было устанавливать камеры с управлением движением для точной съемки моделей при разных условиях освещенности. Оставшуюся часть здания занимали комнаты, заполненные специалистами по компьютерной графике, которые монтировали отснятые материалы с цифровыми эффектами, формируя изображения. Эти комнаты постепенно вытеснили модельный цех и платформы, а оставшийся небольшой участок сцены в основном используется для цифрового сканирования исполнителей и объектов. Модельного цеха больше нет – при потребности в моделях они заказываются на стороне, а все эффекты генерируются с использованием компьютеров.

Однако реальные визуальные эффекты исчезли не совсем. Например, в «Темном рыцаре», снятом в 2008 году, директор фильма Кристофер Нолан хотел получить правдоподобие, достижимое только с помощью таких эффектов. Его группа спецэффектов использовала сложный такелажный механизм для перевертывания грузовика на улице в деловой части Чикаго в одной из центральных частей фильма. Постановка эффектов старой школы исключительно опасна и расходна, но она гарантирует реалистичность.

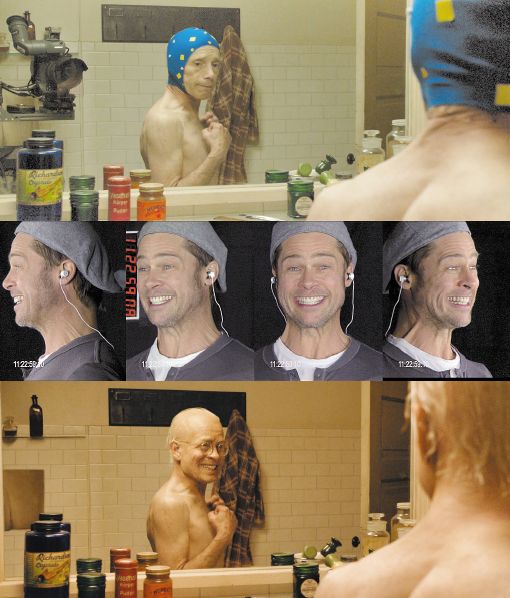

Методы CGI достигли такого уровня развития, что для внешних наблюдателей часто бывает трудно распознать, в каких сценах используются визуальные эффекты. Примером является виртуальный образ постаревшего Брэда Питта в «Загадочной истории Бенджамина Баттона», созданный специалистами Digital Domain (рис. 1).

Статью «Виртуальная графика в производстве телепрограмм» (Virtual Graphics for Broadcast Production) написали Грэхем Томас и Оливер Грау (Graham Thomas, Oliver Grau). Виртуальная графика теперь стала общераспространенным компонентом телевизионных программ. Начиная с простейшей карты погоды за спиной ведущего программы и кончая сложной трехмерной графикой, показывающей положения бегунов на дистанции или ситуацию «вне игры» на футбольных состязаниях, эта графика помогает производителям телевизионных программ донести до зрителей информацию в простой для понимания и визуально наглядной форме. Использование этой графики позволяет сократить стоимость производства обычных программ за счет замены частей декораций компьютерными изображениями.

Новые разработки обещают еще больше расширить области проникновения трехмерной графики и помочь развитию кросс-платформного контента. Хотя большинство элементов технологии, с помощью которой виртуальная графика добавляется к телевизионным программам, являются теми же, что используются в индустрии кинематографии, их применение на телевидении существенно отличается скоростью производства и уровнем совершенства. В то время как на создание кинофильма обычно тратится много времени и у киностудии есть финансовые возможности поддерживать многомесячное компьютерное редактирование, при производстве телевизионных программ бюджет редко это позволяет. Кроме того, в данном случае не требуется производить контент с высоким уровнем разрешения, зато многие виды программ, нуждающихся в виртуальной графике, транслируются в реальном времени или, по крайней мере, время от их записи до трансляции не должно превышать несколько часов.

В любой программе, рассчитанной на существенное взаимодействие реального и виртуального контента, также требуется вставка виртуального контента в изображение в реальном времени в течение записи, так чтобы оператор мог соответствующим образом собирать общую картинку, а участники программы могли видеть, как они взаимодействуют с виртуальным контентом. В статье обсуждаются вопросы использования виртуальной графики при производстве телепрограмм.

Авторы статьи «Визуальные эффекты в компьютерных играх» (Visual Effects in Computer Games) – Ксюбо Янг, Мило Йип и Ксиаою Ксу (Xubo Yang, Milo Yip, Xiaoyue Xu). Компьютерные игры дали жизнь индустрии, которая постоянно наращивает объем интерактивного контента и обеспечивает новые впечатления от процесса игры. Кроме новшеств в основной сюжетной линии и режимах игры, в рекламе новых игр часто упоминаются визуальные эффекты. Например, у игры Far Cry 2 компании Ubisoft имеется много увлекательных особенностей, таких как изменяющиеся погодные условия, освещение и т.д.

В компьютерных играх все графические эффекты являются визуальными, однако авторы опираются на более узкое определение визуальных эффектов, имея в виду графические эффекты, используемые для специальных целей. Эти эффекты часто моделируют некоторые явления жизни и могут вызывать у игрока особое эмоциональное ощущение за счет, например, использования объемного тумана для создания духа таинственности.

Последнюю статью тематической подборки – «Смягчение границ между фантазией и реальностью» (Melting the Boundaries between Fantasy and Reality) – представили Скотт Траубридж и Кристофер Стейплтон (Scott Trowbridge, Christopher Stapleton). Искусство и наука создания иллюзий в индустрии иммерсивных (то есть создающих комплекс ощущений) развлечений направлены на воздействие на все чувства человека. Крайним примером иммерсионных развлекательных предприятий можно считать парки аттракционов, в которых разработчики и сценаристы погружают публику в некую воспринимаемую ею реальность, действительную или представляемую.

Это несравнимо ни с одним другим видом развлекательных предприятий, поскольку иллюзия может поддерживаться для тысяч людей в течение нескольких минут, целого дня или даже недели. При наличии таких объемов зрительского критического внимания важной проблемой является применение в парках аттракционов машинно-генерируемого контента.

В статье авторы применяют свой опыт и результаты исследований в областях организации парков аттракционов и имитационного моделирования для описания того, как наука объединяется с фантазией для устранения границ между воображением автора сценария и неизбежной реальностью физического мира, а также для слияния машинно-генерируемого контента с реальной средой иммерсивного развлечения.

Вне тематической подборки опубликованы две большие статьи. Мухамад Али Бабар и Ян Гортон (Muhammad Ali Babar, Ian Gorton) представили статью под названием «Анализ архитектур программного обеспечения: практическое состояние» (Software Architecture Review: The State of Practice). Предположим, что у вас завершается работа над программной архитектурой некоторой программной системы стоимостью в несколько миллионов долларов. На чем основывается ваша уверенность в том, что архитектурные решения, на которых будет основываться разработка, приведут к созданию системы, отвечающей поставленным бизнес-целям? Насколько вы уверены в том, что проект не затянется из-за технических переделок уже готовых компонентов, потребность в которых вызывается неудачными архитектурными решениями?

Анализ архитектуры является эффективным способом обеспечения качества разработки и решения архитектурных проблем. Основные цели анализа программной архитектуры – оценка возможности архитектуры удовлетворять требованиям качества и определение потенциальных рисков. Для поддержки организаций, выполняющих анализ, несколько рабочих групп, включая группу по анализу и оценке программных архитектур Software Architecture Review and Assessment (SARA), выпустили отчеты, обобщающие практику выполнения такого анализа. Однако, кроме отчетов AT&T, Avaya Labs и Lucent Technologies, мало где говорится о состоянии дел в области анализа архитектур в софтверной индустрии в целом. Для исследования этой проблемы авторы организовали опрос в сообществе программной инженерии.

Авторов вопросника прежде всего интересовало, насколько формально определен процесс анализа архитектуры в организациях-участниках опроса: 56% респондентов ответили, что в их организациях процесс анализа формально не определен, 41% используют формально определенный процесс, а у 3% процесс анализа меняется от проекта к проекту. Следующий вопрос касался методов, используемых при анализе архитектуры программного обеспечения. Оказалось, что наиболее распространены две разновидности методов: логические рассуждения на основе предыдущего опыта (83%) и прототипирование (70%). Многие участники также упоминали использование сценариев (54%) и таблиц контрольных проверок (40%). Только 5% участников ответили, что при оценке архитектурных решений в их организациях используются математические модели.

Задавался также вопрос о критериях, применяемых компаниями при выборе конкретных методов анализа архитектуры. В своих ответах респонденты упоминали различные технические, организационные, социальные и связанные с бизнесом факторы, которые влияют на выбор конкретных методов. К числу основных факторов, по мнению участников опроса, относятся следующие: атрибуты качества, такие как эффективность, эксплуатационная пригодность и безопасность; размер и сложность системы; доступность персонала, имеющего опыт применения соответствующих методов анализа; временные рамки и бюджет проекта; требования заказчиков; политика организации; предпочтения менеджера проекта. Однако ни один респондент ничего не сказал о применении при выборе методов анализа каких-либо стандартов или руководств.

В исследовательском сообществе анализа архитектур разработано несколько специальных методов, предназначенных для поддержки процесса анализа. Такие методы, как Scenario-Based Architecture Analysis Method (SAAM, www.sei.cmu.edu/architecture/scenario_paper), Architecture Level Maintainability Analysis (ALMA), Architecture Tradeoff Analysis Method (ATAM, www.sei.cmu.edu/ata/iceccs.pdf) и Performance Analysis of Software Architecture (PASA), широко обсуждались в литературе по программной инженерии. Авторы хотели узнать, насколько практики знакомы с этими и другими методами анализа. Оказалось, что 24% опрошенных знали про SAAM и ATAM, 17% – про PASA и только 6% – про ALMA. Еще хуже дела обстоят с использованием этих методов: 5% респондентов говорили об использование SAAM и ATAM, и только один респондент упомянул о применении PASA и ALMA.

Последняя статья июльского номера называется «Канальная электронная почта: социально-технический ответ на спам» (Channel E-mail: A Sociotechnical Response to Spam), написана она Брайаном Витвортом и Тонгом Лиу (Brian Whitworth, Tong Liu). На сегодняшний день около 80% из 460 млрд ежегодно посылаемых сообщений электронной почты является спамом, на передачу и обработку которого впустую тратятся ресурсы. В первый раз объем спама превысил объем полезных сообщений в мае 2003 года, и поставщикам услуг Internet, использующим один сервер для передачи электронной почты клиентам, стал нужен еще один сервер для удаления поступающего спама.

В 2003 году американские компании понесли убыток от спама в 10 млрд долл., а в 2004 году убыток в расчете на одного служащего составил 1934 долл., не считая ИТ-персонала, расходов на программное обеспечение и оборудование и т.д. По оценкам на 2005 год, потери в мировом масштабе составляют 50 млрд долл.

Несмотря на то что глобальная система электронной почты эффективна с технической точки зрения (информация передается нормально), она неэффективна с точки зрения общества (содержательная информация передается все хуже и хуже). И вряд ли стоит удивляться, что система, разработанная на основе чисто технических требований до того, как Internet стал общественной средой, не выполняет должных социальных функций.

Спам представляет собой старую социальную проблему в новом техническом обличье, фактически это электронное воплощение так называемой «трагедии общин». Это социально-техническая проблема, которую невозможно разрешить ни чисто техническими, ни чисто социальными средствами (например, посредством законов). Для решения социально-технических проблем требуются социально-технические решения. И в качестве такого решения авторы предлагают канальную электронную почту.

При применении социально-технического подхода должны соблюдаться коммуникационные права человека, гарантирующие, что: для обмена сообщениями электронной почты требуется взаимное согласие граждан; любой человек имеет право отвергнуть общение; любой человек может запросить общение по электронной почте, послав краткий запрос, идентифицирующий его самого и цели общения; общение происходит в виде поочередного обмена сообщениями, без каких-либо дальнейших предуведомлений; любой участник может в любой момент прекратить общение.

В канальной электронной почте эти требования поддерживаются за счет создания специального канального объекта, через который посылаются сообщения. Вместо управления сообщениями пользователи управляют каналами, через каждый из которых можно обмениваться многими сообщениями. Канал, созданный на основе взаимного согласия, обеспечивает участникам возможность свободно обмениваться сообщениями, как и при использовании традиционной электронной почты.

Где бы еще покопаться в данных?

Тема августовского номера журнала Computer (IEEE Computer Society, V. 42, No 8, August 2009) – интеллектуальный анализ данных (data mining) и машинное обучение (machine learning).Теме посвящены четыре статьи, которым предшествует небольшая вводная заметка приглашенного редактора Нарена Рамакришнана (Naren Ramakrishnan) «Вездесущность интеллектуального анализа данных и машинного обучения» («The Pervasiveness of Data Mining and Machine Learning»). Многие исследователи проводят различия между data mining и machine learning, что говорит о том, на чем акцентируются и откуда происходят исследования, хотя в последнее время наблюдается взаимное обогащение идеями и перемещение авторов между соответствующими сообществами.

Первая основная статья подборки написана Иегудой Кореном, Робертом Беллом и Крисом Волински (Yehuda Koren, Robert Bell, Chris Volinsky) и называется «Методы факторизации матриц для систем рекомендаций» («Matrix Factorization Techniques for Recommender Systems»). У современных потребителей имеется масса возможностей выбора — электронные розничные магазины и поставщики контента предлагают огромный ассоортимент продуктов, способный удовлетворить самым разнообразным потребностям и вкусам. Поэтому все больше розничных торговцев нуждается в системах рекомендаций, которые анализируют характер предпочтений пользователей и вырабатывают персонифицированные рекомендации и вырабатывают персонифицированные рекомендации. В частности, системы рекомендаций стали существенной частью Web-сайтов лидеров электронной коммерции, таких как Amazon.com (www.amazon.com) и Netflix (www.netflix.com).

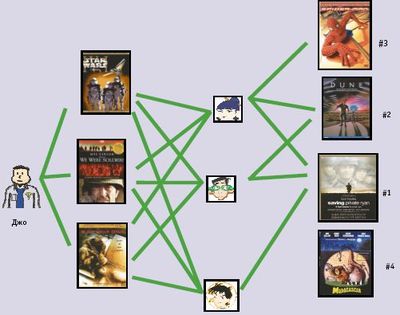

Грубо говоря, системы рекомендаций основываются на одной из двух стратегий. При использовании подхода фильтрации контента (content filtering) для каждого пользователя или продукта создается профиль, характеризующий его основные свойства. Например, профиль фильма может включать такие атрибуты, как жанр, список актеров, кассовые сборы и т.д., позволяя программам связать пользователей с подходящими им продуктами. Альтернативный подход к организации систем рекомендаций опирается только на данные о предыдущем поведении пользователей и не требует создания явных профилей. Этот подход называется совместной фильтрацией (collaborative filtering) (термин был введен разработчиками первой системы рекомендаций Tapestry, www.ischool.utexas.edu/~i385d/readings/Goldberg_UsingCollaborative_92.pdf). При использовании совместной фильтрации для нахождения новых ассоциаций анализируются связи между пользователями и взаимозависимости между продуктами. Привлекательной чертой подхода совместной фильтрации является то, что он не привязан к какой-либо прикладной области и может применяться по отношению к тем аспектам данных, для которых трудно применять профилирование. Хотя, как правило, совместная фильтрация обеспечивает лучшую точность рекомендаций, чем фильтрация контента: этому подходу свойственна проблема «холодного» старта когда система не может работать с данными о новых пользователях и продуктах. Двумя основными областями применения совместной фильтрации являются методы ближайших соседей (nearest neighborhood method) и модели скрытых признаков (latent factor model). В первом случае предпочтение пользователем некоторого продукта оценивается на основе его оценок «соседних» продуктов. Например, пусть требуется оценить предпочтение пользователя по отношению к фильму «Спасти рядового Райана». «Соседями» этого фильма могли бы быть другие фильмы о войне, другие фильмы Стивена Спилберга, другие фильмы, в которых снимался Том Хэнкс и т.д. Во втором случае определяются пользователи-единомышленники, оценки каждого из которых дополняют оценки любого другого пользователя той же группы (рис. 2).

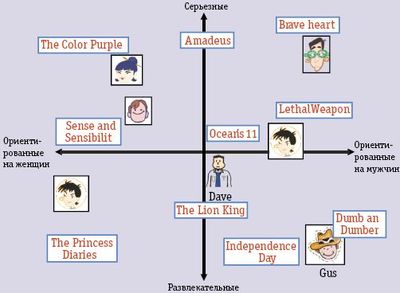

При применении моделей скрытых признаков система пытается истолковать оценки путем получения характеристик и продуктов, и пользователей, используя при этом от 20 до 100 признаков, выводимых из структуры оценок. По сути, такие признаки являются компьютеризованной альтернативой генов песен. Для фильмов такие признаки могут включать очевидные измерения, такие как жанр, динамичность сюжета, ориентация на детей, глубина раскрытия образов или причудливость фильма. Каждый признак пользователей показывает, насколько нравятся данному пользователю фильмы, высоко оцениваемые в измерении соответствующего признака фильмов. На рис. 3 эта идея иллюстрируется на упрощенном примере с двумя измерениями. Рассмотрим два гипотетических измерения, характеризующих ориентацию фильмов на женщин или мужчин и серьезный или развлекательный жанр фильмов. На рисунке показано, как в этом двухмерном пространстве могло бы быть размещено несколько известных фильмов и несколько фиктивных пользователей.

В этой модели дана предсказываемая оценка некоторого фильма некоторым пользователем относительно средней оценки данного фильма. Например, можно было бы ожидать, что пользователю Гасу понравится фильм «Тупой, еще тупее» («Dumb and Dumber»), не понравится фильм «Цветы лиловые полей» («The Color Purple») и что он средним образом оценит фильм «Храброе сердце» («Braveheart»). Заметим, что в этом пространстве некоторые фильмы (например, «Одиннадцать друзей Оушена») и некоторые пользователи (например, Дейв) характеризовались бы полностью нейтральным образом.

Статью «Оптимизация сбора сенсорных данных: из воды в Web» (Optimizing Sensing: From Water to the Web) представили Андреас Краузе и Карлос Герстин (Andreas Krause, Carlos Guestrin). Высокий уровень загрязняющих веществ в водоемах может приводить к быстрому росту водорослей, что становится серьезной угрозой ресурсам питьевой воды. Например, цветение воды в июне

2007 г. в озере Тайху в китайской провинции Цзянсу лишило питьевой воды четыре миллиона человек.

Многие процессы, связанные с цветением воды, все еще недостаточно хорошо поняты, и изучать их нужно в озерах, а не в лабораториях. Естественный подход к получению новых знаний состоит в мониторинге параметров окружающей среды, и перспективная технология для этих целей опирается на использование датчиков, установленных на роботизированные лодки, позволяющие получать измерения на больших площадях. Однако для получения каждого измерения требуется значительное время, поскольку роботу требуется доплыть из одной точки водной поверхности в другую. Поэтому важно планировать траекторию лодки, чтобы получить как можно больше полезной информации об изучаемом явлении. Аналогичная проблема возникает в контексте мониторинга муниципальных распределительных сетей питьевой воды. Случайное или злонамеренное загрязнение таких сетей может затронуть большую группу населения и нанести серьезный ущерб. Потенциально такое загрязнение можно выявить путем размещения датчиков в сети водопроводов. Однако эти сенсоры весьма дороги (порядка 10 тыс. долл), поэтому необходимо оптимизировать их размещение, чтобы добиться их максимальной эффективности.

В статье описывается новый класс алгоритмов с теоретически обоснованными гарантиями эффективности, которые могут масштабироваться к крупным проблемам оптимизации сбора сенсорных данных. Алгоритмы основываются на том наблюдении, что многие проблемы удовлетворяют свойству подмодульности (submodularity) – интуитивному свойству убываемой отдачи: лучше добавить наблюдение в тот участок, где делалось мало наблюдений, чем туда, где уже было выполнено много наблюдений.

Авторами следующей статья являются 12 авторов из Абериствисского и Кембриджского университетов (Великобритания), а статья называется «Робот-ученый Адам» (The Robot Scientist Adam). Применение компьютерных наук приводит к изменению способов представления и передачи исследователями научных знаний. Большая часть этих знаний представляется с использованием только естественного языка, за исключением математики. Желание сделать научные данные более пригодными для компьютерного анализа стимулирует развитие таких направлений, как онтологии и Semantic Web.

Ветвь искусственного интеллекта, посвященная научным приложениям, называется обнаружением научных знаний (scientific discovery). Первыми достижениями в этой области были разработанные в 1960-е гг. системы анализа масс-спектрометрических данных Dendral и Meta-Dendral, ставшие одними из первых систем машинного обучения. Однако большинство программ обнаружения научных знаний разрабатывалось в расчете на выработку ответа и «не замыкали круг» в том смысле, что не принимали решения о следующих шагах на основе анализа результатов экспериментов, не выполняли потенциально бесконечную циклическую последовательность исследований. У большей части систем обнаружения научных знаний имеется еще одно важное ограничение – отсутствие возможности выполнять свои собственные эксперименты. Эта возможность требуется, чтобы такие системы могли выполнять работу в лабораториях в полуавтономном режиме.

Роботы-ученые – это естественное развитие тенденции широкого использования компьютерных систем в науке. В этих системах применяются разнообразные методы искусственного интеллекта для автоматического выполнения циклов научных экспериментов. Робот-ученый генерирует гипотезы, объясняющие наблюдения; разрабатывает эксперименты для проверки этих гипотез; интерпретирует результаты экспериментов; затем повторяет этот цикл.

С философских позиций основной довод в пользу таких систем состоит в том, что мы не сможем полностью понять какое-либо явление, пока не сконструируем машину, воспроизводящую его. В 2004 году авторы предложили свою концепцию робота-ученого и продемонстрировали его возможности по автоматическому выполнению циклов формирования гипотез и экспериментов. Следующая модель робота-ученого Adam позволяет полностью автоматически выполнять микробиологические эксперименты.

Последняя статья тематической подборки называется «Интеллектуальный анализ данных в программной инженерии» (Data Mining for Software Engineering) и написана Тао Ксаем, Сурешем Таманелентой, Дэвидом Ло и Чао Лиу (Tao Xie, Suresh Thummalapenta, David Lo, Chao Liu). Поскольку программное обеспечение играет решающую роль в бизнесе, правительственных и общественных организациях, важной целью программной инженерии является совершенствование эффективности и качества программного обеспечения. Достижению этой цели могут способствовать средства интеллектуального анализа данных программной инженерии.

Популярные системы управления версиями программного обеспечения, такие как CVS и Subversion, позволяют разработчикам не только сохранять мгновенные снимки текущей базы кодов, но также и поддерживать полную историю версий. На основе систем, подобных Bugzilla, возможно организовать учет и обработку ошибок на протяжении всего жизненного цикла программной системы. Мощные измерительные средства, такие как Dr. Watson компании Microsoft, позволяют получать разнообразные данные во время выполнения программ. Эти средства используются разработчиками, а также в инструментах мониторинга программных систем уровня конечных пользователей.

Алгоритмы интеллектуального анализа данных применимы к различным задачам программной инженерии, например могут помочь разобраться в том, как вызывать методы API, поддерживаемые в сложной и недостаточно полно документированной библиотеке. При поддержке программного обеспечения алгоритмы data mining могут способствовать определению того, какие части кода требуется изменить при изменении других частей кода.

Вне тематической подборки опубликованы две большие статьи. Чарльз Рич (Charles Rich) представил статью «Создание пользовательских интерфейсов, основанных на описании задач, с применением стандарта ANSI/CEA-2018» (Building Task-Based User Interfaces with ANSI/CEA-2018). Исследования показывают, что половина возвращаемой в магазины якобы неисправной бытовой электроники на самом деле полностью работоспособна – покупатели просто не смогли разобраться, как с ней обращаться. Логическим решением проблемы была бы стандартизация, но, к сожалению, компании-производители бытовой электроники неуклонно противодействуют всем попыткам стандартизации пользовательских интерфейсов устройств с однотипными функциями, полагая, что внешнее представление и функциональные особенности их интерфейсов важны для идентификации бренда, а любые шаги к стандартизации чреваты снижением прибыли.

Недавно принятый стандарт ANSI/CEA-2018 (ce.org/cea-2018) прямо способствует решению проблемы сложности, обеспечивая новый вид взаимодействия пользователя с системой без стандартизации внешнего вид пользовательского интерфейса. Эта хитроумная (но необходимая) стратегия может привести к значительному повышению уровня удобства использования бытовой электроники и программного обеспечения в целом.

Статью «Шаблоны специализированных продуктов» (Application-Specific Product Generics) написали Джон Лэч и Вину Виджай Кумар (John Lach, Vinu Vijay Kumar). Повышение стоимости проектирования и производства полупроводниковых приборов приводит ко все большей потребности в мелкосерийных специализированных заказных устройствах. Стоимость проектирования возрастает экспоненциально в зависимости от сложности системы, а процессы производства полупроводниковых устройств становятся все более сложными и трудоемкими – одна только стоимость изготовления маски часто превышает миллион долларов.

Эта суровая действительность стимулирует разработчиков аппаратных средств агрегировать несколько мелкосерийных проектных решений в более крупное обобщенное решение, сокращая тем самым невозвращаемую стоимость проектного этапа. Имеющиеся в настоящее время подходы к созданию таких обобщенных проектных решений опираются на использование специализированных интегральных схем (application-specific integrated circuits, ASIC), настраиваемых процессоров (customizable processor) и программируемых логических матриц (field-programmable gate array, FPGA). Однако за уменьшение стоимости приходится расплачиваться недостаточной миниатюрностью, не слишком высокой производительностью и слишком большой потребляемой мощностью.

Новый подход «шаблонов специализированных продуктов» (Application-specific product generics, ASPG) обеспечивает достаточную гибкость, позволяющую реализовать целое семейство устройств на основе единого этапа проектирования и запуска производства, но при этом показатели получаемых устройств близки

к показателям заказных ASIC.

До новой встречи, с уважением, Сергей Кузнецов, kuzloc@ispras.ru