Обеспечивая надежную эксплуатацию ИТ, вентиляторы и системы климатизации в серверных комнатах и вычислительных центрах обычно работают на полную мощность. Цена высока в самом прямом смысле слова: затраты растут взрывоподобно. Помочь обуздать их может так называемое «тепловое исследование» (Thermal Assessment), которое позволяет идентифицировать поглотителей энергии и выявить возможности экономии.

Давно известно, что, заботясь о защите окружающей среды, сократить потребление энергии должны именно промышленно развитые страны, к тому же уже сегодня недешевая энергия в дальнейшем будет только дорожать. Даже в высокотехнологичных областях, к примеру, в современных вычислительных центрах, эксперты все еще сталкиваются с давно известной проблемой: энергопотребление лавинообразно увеличивается, и, следовательно, растет потребность в охлаждении. И дело не только в том, что оборудование становится все более компактным (появились, в частности, модульные серверы), но и в том, что выпускаются и очень мощные процессоры. По разным оценкам, около 60% расходов на энергию в области ИТ приходится на серверные комнаты. Кроме того, в вычислительных центрах на обеспечение питанием выделяется вторая по величине сумма — большие средства тратятся только на аппаратное обеспечение.

Давно известно, что, заботясь о защите окружающей среды, сократить потребление энергии должны именно промышленно развитые страны, к тому же уже сегодня недешевая энергия в дальнейшем будет только дорожать. Даже в высокотехнологичных областях, к примеру, в современных вычислительных центрах, эксперты все еще сталкиваются с давно известной проблемой: энергопотребление лавинообразно увеличивается, и, следовательно, растет потребность в охлаждении. И дело не только в том, что оборудование становится все более компактным (появились, в частности, модульные серверы), но и в том, что выпускаются и очень мощные процессоры. По разным оценкам, около 60% расходов на энергию в области ИТ приходится на серверные комнаты. Кроме того, в вычислительных центрах на обеспечение питанием выделяется вторая по величине сумма — большие средства тратятся только на аппаратное обеспечение.

В частном секторе давно применяются хорошая изоляция, экономичные электролампы, рекуперация тепла или полное отключение электрических устройств от сети (вместо перехода в спящий режим) — все эти отдельные меры позволяют добиться немалой экономии. Но снизить затраты на питание вычислительного центра, причем в долгосрочной перспективе, удастся лишь при наличии интегрированной стратегии. Она должна учитывать не только отдельные компоненты, но распространяться на всю инфраструктуру.

В идеальном случае планирование предполагает предварительный анализ серверных помещений и вычислительного центра. Результаты такого «теплового исследования» могут оказаться неожиданными, поскольку, как известно, «дьявол таится в деталях» — к примеру, обнаружится неудачная конфигурация стойки или неблагоприятное распределение потоков данных. Но в этом есть и положительная сторона: если слабые места известны, их можно устранить.

ПРИНЦИП РАБОТЫ

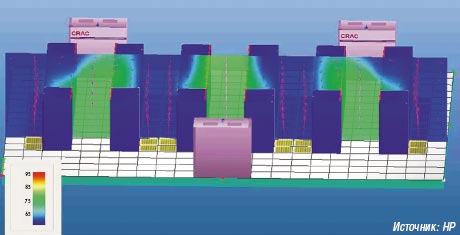

Чтобы выявить главных поглотителей энергии, а также потенциал для оптимизации подачи питания, специалисты в области охлаждения подробно изучают вычислительный центр, фиксируют его особенности и составляют план. Как известно, вся потребляемая компьютером энергия преобразуется в теплоту, которую необходимо отвести. Поэтому в стандартную программу теплового исследования входят контрольные измерения поверхностной температуры. Как правило, оборудование можно эксплуатировать, когда с передней стороны устройства температура охлаждающего воздуха не превышает 25°C (если производитель не установил иных ограничений), тогда как температура у его задней стенки может достигать примерно 50°C.

ПОЧЕМУ АНАЛИЗ ТОГО СТОИТ?

Затраты на разработку подробной «модели климата» вычислительного центра площадью от 60 до 100 м2 обойдутся приблизительно в 8 тыс. евро и более. Провести такой анализ рекомендуется не только крупным предприятиям — затраты на тепловое исследование окупаются быстро, даже если предприятие невелико. Новейшие исследования показывают, что удельное энерговыделение в вычислительных центрах не зависит от их размера и за последние десять лет выросло более чем в десять раз. В некоторых случаях свыше 70% общего энергопотребления приходится на одно только охлаждение вычислительного центра. Обоснованный анализ позволяет предприятиям добиться эффективного использования энергии, сократить затраты и оптимально спланировать новые системы. Если организация намерена оснастить свой серверный парк, не полагаясь на результаты профессионального теплового исследования, она неизбежно попадет в заколдованный круг: увеличение мощности на все меньшей площади означает увеличение выделения тепла; увеличение выделения тепла требует эффективной системы охлаждения; более мощная система охлаждения означает увеличение потребления энергии для отвода тепла. В результате растут затраты на энергию.

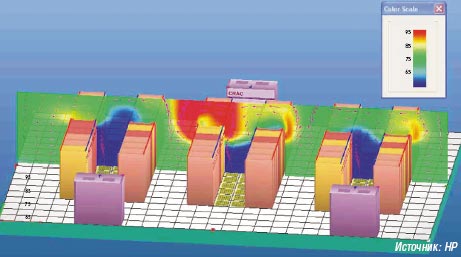

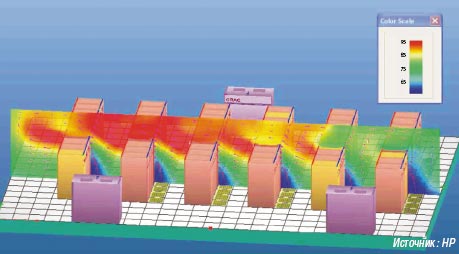

Даже в хорошо продуманных вычислительных центрах планировщики часто недооценивают значение архитектуры охлаждения. Распространенные системы охлаждения обычно поддерживают мощность от 600 до 800 Вт/м2. Она часто оказывается недостаточной для выпускаемых сегодня компьютеров, которые предлагают все большую производительность на все меньшей площади, что значительно увеличивает выделение теплоты. Впрочем, горячие зоны могут образовываться и когда мощность системы охлаждения соответствует норме — это происходит, когда засасываемый воздух слишком горяч для охлаждения. Тогда возникает круговорот разогревающегося воздуха, и ущерба для оборудования уже не избежать. Кроме того, управление климатическими системами, как правило, происходит в соответствии с системой Delta-T, учитывающей разницу температур поглощаемого и выдуваемого воздуха. Если картина воздушных потоков определена неправильно, это приводит к тому, что в климатическую систему попадает слишком холодный воздух, из-за чего производительность охлаждения может снизиться. При отсутствии в вычислительном центре соответствующей концепции для охлаждения отдельных областей и компонентов все серверные комнаты приходится охлаждать больше, чем требуется, что не только увеличивает потребление энергии, но способствует конденсации водяных паров, а значит, появляется угроза коррозии.

Еще одной деталью, о которой часто забывают, являются двойные полы. В большинстве случаев они служат и для прокладки кабелей, что при правильном планировании циркуляции воздуха не представляет какой-либо проблемы. Но иногда двойные полы содержат и трубы для отвода отработанной воды — а это уже серьезное препятствие для воздушных потоков. Довольно часто выпускные отверстия пола не закрываются, в таком случае возникает нежелательное смешивание холодного и теплого воздуха. С одной стороны, такой процесс оказывает влияние на соотношение давления под полом, а с другой — ведет к тому, что при открытых выпускных отверстиях поток воздуха мощностью охлаждения 500 Вт и более попадает в теплый проход. Любой из этих аспектов можно легко устранить — при условии, что о подобных деталях известно. Упущения в вопросах охлаждения могут обойтись дорого, поскольку диагноз примерно трети серверных отказов звучит просто: перегрев.

Любой вычислительный центр представляет собой растущую нестандартизованную область, которая развивается согласно собственным правилам. Но все комплексы такого рода похожи в одном: их средний цикл обновления составляет от десяти до двадцати лет. Поэтому при создании вычислительного центра важнейшим аспектом является сохранность сделанных инвестиций, причем решающую роль играет эффективность использования энергии — и не только из-за того, что благодаря экономии остается больше возможностей для инвестиций в ИТ. Уделяя повышенное внимание эффективности использования энергии при объединении отдельных компонентов, конфигурировании стойки, выборе метода охлаждения, климатизации и построении вычислительного центра, предприятие создает условия для развертывания гибкой масштабируемой инфраструктуры.

Кроме того, надежность инвестиций означает соблюдение определенных стандартов: документы о сертификации, например, требуют предъявить страховые компании или даже деловые партнеры, а провайдеры или поставщики услуг получают их, к примеру, лишь тогда, когда могут доказать, что принадлежащие им вычислительные центры отвечают законодательным требованиям. К таковым, наряду с многими другими факторами, относится и оптимальное охлаждение. При этом вовсе не обязательно применять самые последние технологии — скорее, следует найти правильные пропорции между новыми и уже проявившими себя методами.

В рамках двухступенчатой концепции можно охлаждать такие компоненты, как процессоры или жесткие диски, при помощи воздуха, который, в свою очередь, пропускается через водный теплообменник, причем в модуле, который размещается рядом со стандартной стойкой ИТ. Благодаря этому методу жидкость через стойку не прокачивается, и тем не менее от сервера отводится до 90% тепла. Эффект таков: требования к производительности системы климатизации вычислительного центра падают, а общая производительность охлаждения растет. Тем не менее предприятия, которые оставляют для себя вопрос о водном охлаждении открытым, изначально должны планировать большую площадь для размещения соответствующих систем.

Компаниям следует придавать особое значение составлению планов подключения и прокладки инфраструктуры и постоянному их обновлению. Это позволит обеспечить прозрачность и облегчит стратегическое планирование при изменении инфраструктуры.

Франк Донат — менеджер по развертыванию решений в германском подразделении компании HP.

© AWi Verlag

Правильный расчет

Именно неосведомленность в особенностях функционирования архитектуры охлаждения, вернее, некорректность самостоятельных расчетов приводит к критическим ситуациям в центрах обработки данных. Попытка сэкономить на разработке «модели климата» за счет отказа от привлечения профессионалов обусловливает незащищенность последующих инвестиций в ЦОД. Если взять в расчет тот факт, что в некоторых случаях более 70% общего энергопотребления уходят на одно только охлаждение вычислительного центра, то корректный расчет позволит существенно оптимизировать затраты на эксплуатацию.

Для правильного выбора климатического оборудования необходим тщательный расчет, основанный на множестве факторов. Главные критерии — плотность тепловыделения серверного оборудования (единица измерения — кВт на стойку) и общий объем тепловыделения в помещении. Кроме того, во внимание принимаются такие факторы, как наличие фальшпола и окон, особенности материала, из которого изготовлены стены, направление теплых и холодных воздушных потоков, необходимость пароувлажнения.

Затраты на выполнение такого теплового расчета могут составлять примерно 7% от стоимости климатического оборудования, или 3-10 тыс. евро для помещения 20-100 м2. Однако зачастую производители и поставщики, в частности Emerson Network Power, делают подобные расчеты бесплатно при условии реализации проекта с применением выпускаемого ими климатического оборудования.

В таком случае предусматривается не только создание климатической модели, но и оптимизация внутренней архитектуры расстановки эксплуатируемого оборудования. Неправильное расположение машин, как и неудачная конфигурация стоек, может привести к появлению завихрений теплого воздуха и, как следствие, к перегреву техники, не рассчитанной на работу в условиях повышенных температур.

Согласно статистике, причиной трети серверных отказов является именно перегрев. Вся потребляемая машиной энергия преобразуется в теплоту, которую необходимо отвести от устройства. Однако рекомендованная температура составляет 25°С, и попытка избежать перегрева посредством задания общей температуры значительно ниже требуемой, например 21°С, приводит к образованию конденсации водяных паров и, следовательно, к коррозии критически важных элементов оборудования.

Увеличение производительности за счет расширения парка эксплуатируемого оборудования незамедлительно оборачивается ростом энергопотребления центров обработки данных в целом. В свою очередь, вследствие роста тепловыделения появляется потребность в дополнительном охлаждении. Выход из этого замкнутого круга только один — реализация интегрированной стратегии всей инфраструктуры объекта.

Резюмируя вышесказанное можно сказать, что только серьезный анализ позволит предприятию добиться более эффективного использования энергии и сокращения затрат, а так же изначально оптимально спланировать новые системы при построении вычислительного центра. Упущения могут обойтись дорого!

Нигов Александр — продакт-менеджер департамента энергетического оборудования и климатических систем MAS Elektronik AG